CEO, ¿ESTÁS DISPARANDO UNA BENGALA EN MEDIO DE LA TORMENTA DE LA INTELIGENCIA ARTIFICIAL?

La realidad del liderazgo hoy: navegar o ahogarse Imagina una escena que probablemente ya conoces: estás en mitad de un océano agitado. El agua te llega al pecho. No es agua normal: son olas de datos, automatizaciones, algoritmos y decisiones que se acumulan sin pausa. Sobre ti, una tormenta cerrada. La Inteligencia Artificial ha acelerado el ritmo, ha aumentado la presión y ha introducido una incertidumbre real en la forma de dirigir empresas. 🚨 El escenario: ¿te reconoces aquí? Como CEO, levantas el brazo y disparas una bengala roja. No por pánico, sino por conciencia. Sabes que necesitas ayuda estratégica, no soluciones improvisadas ni herramientas sueltas. No estás solo en el agua. 🦈 Los tiburones nadan cerca: competencia más ágil, startups nativas en IA, y también frenos internos, resistencias culturales y decisiones pospuestas. 🐬 Los delfines también están ahí: innovación, oportunidades reales, equipos con potencial, tecnología bien aplicada. El problema es claro: sin un barco, las amenazas siempre parecen más grandes que las oportunidades. 🚤 La solución: 4 salvavidas para convertir la tormenta en ventaja No necesitas suerte. Necesitas un sistema profesional para navegar este contexto. El barco no promete milagros: lanza 4 salvavidas estratégicos: 1️⃣ Formación en el nuevo reglamento europeo de IA ⚖️ Sin seguridad jurídica no hay liderazgo. Conocer las reglas y formar al equipo es el primer chaleco. 2️⃣ Diagnóstico de madurez digital 📊 Antes de avanzar, hay que saber dónde estás y qué estructura real soporta la presión. 3️⃣ Plan estratégico de Inteligencia Artificial 🗺️ No es implantar IA, es decidir para qué, dónde y con qué impacto. 4️⃣ Implantación de casos de uso de IA 🤖 Aquí los delfines juegan a tu favor: pasar de la teoría a resultados reales. 💡 Conclusión: de la urgencia al liderazgo consciente La tormenta no va a parar. Pero tu forma de navegarla sí puede cambiar. El objetivo no es sobrevivir, sino convertir la incertidumbre en ventaja competitiva. Liderar hoy implica saber distinguir entre tiburones y delfines… y rodearse del acompañamiento adecuado. ¿Cuál de los 4 salvavidas necesita tu empresa con más urgencia esta semana? Soy Joaquín Rieta, formador y consultor. Ayudo a empresas a implantar IA con método y visión estratégica 📊🧭 www.joaquinrieta.com hashtag#CEO hashtag#LiderazgoEstratégico hashtag#InteligenciaArtificial hashtag#AIStrategy hashtag#TransformaciónDigital hashtag#Innovación hashtag#Management

CEO: ¿Te sientes atrapado en el laberinto de la Inteligencia Artificial?

Imagina tu situación actual. Estás en medio de un gran laberinto moderno. No hay muros de piedra, sino estructuras tecnológicas: circuitos, nodos de datos y geometrías limpias en tonos azules y grises. Todo parece avanzado… pero confuso. El ambiente transmite complejidad e incertidumbre. Sabes que la IA es clave para el futuro, pero el camino no es evidente. Como muchos líderes, te enfrentas a decisiones estratégicas críticas. ¿Te reconoces en alguno de estos escenarios? 👇 🚧 SITUACIÓN 1: Los frenos del equipo Ante ti aparecen muros formados por siluetas humanas inmóviles, brazos cruzados. Representan la resistencia al cambio. Cómo desbloquearlo: 1️⃣ Liderazgo consciente: La IA no se impone, se lidera desde la cultura. 2️⃣ Equipos Humano-IA: No sustitución, sino colaboración entre talento y automatización. 3️⃣ Visión de negocio: Explica cómo la IA beneficia al conjunto, no solo a la empresa. ⛔ SITUACIÓN 2: Inacción y parálisis En otro pasillo el tiempo está detenido. Relojes congelados. Demasiado análisis, ningún paso. Cómo avanzar: 1️⃣ Diagnóstico de IA: Datos, métricas y visión real de tu punto de partida. 2️⃣ Decisión informada: Rompe la inercia con hechos, no con intuición. 3️⃣ Perspectiva CEO: Observa el laberinto desde arriba, no desde dentro. 😱 SITUACIÓN 3: Miedo y niebla digital Sombras, advertencias y preguntas flotan: ¿es legal?, ¿es seguro?, ¿y si me equivoco? Cómo disiparla: 1️⃣ Formación regulatoria: Conocer el Reglamento Europeo de IA aporta luz. 2️⃣ Uso responsable: Cumplimiento normativo como ventaja competitiva. 3️⃣ Claridad estratégica: Un plan documentado elimina la incertidumbre. 🏃 SITUACIÓN 4: La carrera precipitada Una pendiente rápida, señales de peligro. Implementar “todo ya” sin base sólida. Cómo corregir: 1️⃣ Plan estratégico: Roadmap con visión a medio y largo plazo. 2️⃣ Paso firme: Menos impulso, más criterio. 3️⃣ Reflexión: Parar también es una decisión estratégica. ➡️🚀 TU SALIDA: El camino del CEO estratégico 🧠♟️ Solo hay un camino claro e iluminado. No es magia, es liderazgo consciente y estrategia. Al final encontrarás 4 puertas luminosas: ✅ Formación en el Reglamento Europeo de IA ✅ Diagnóstico de Inteligencia Artificial ✅ Plan Estratégico de IA ✅ Implantación real de Casos de Uso La IA no es un laberinto sin salida. Es una herramienta de alto nivel para la dirección que sabe parar, pensar y decidir. ¿En qué punto del laberinto estás hoy? ¿Estás listo para cruzar la puerta correcta? Soy Joaquín Rieta, formador y consultor. Ayudo a empresas a implantar IA con método y visión estratégica 📊🧭 www.joaquinrieta.com hashtag#CEO hashtag#InteligenciaArtificial hashtag#Estrategia hashtag#Liderazgo hashtag#Innovación hashtag#IA hashtag#Management hashtag#Business hashtag#Futuro

CEO, ¿cómo vas a jugar la partida de la transformación con Inteligencia Artificial?

Conoce el marco estratégico para decidir cuando la IA calcula. El 85 % de los líderes cree que la IA transformará su negocio y, sin embargo, menos del 35 % se siente preparado para liderar ese cambio. La brecha no es tecnológica. Es estratégica. Muchos siguen tratando la IA como una herramienta táctica —un peón más— cuando en realidad exige replantear el tablero completo: datos, roles, cultura, decisiones y gobernanza. Y mientras miras a la competencia, tu verdadero oponente avanza: Tu verdadero rival no es solo la competencia. Es un conjunto de fuerzas internas que bloquean cualquier transformación real: ♚ El Rey: la obsolescencia, cuando tu modelo de negocio deja de ser relevante. ♛ La Dama: la cultura del miedo al cambio, que paraliza decisiones e innovación. ♟ Los peones: silos de datos, deuda técnica y burocracia, que parecen pequeños, pero bloquean todo el tablero. Cuando la relevancia de tu empresa cae, no hay tecnología que salve la partida. Es jaque mate. 💡 La solución: jugar al ajedrez, no a las damas. Ganar no va de tecnología, va de orquestación estratégica. 🔹 Apertura: gobernar el centro El centro del tablero es la Gobernanza de Datos + Estrategia. Sin eso, no hay partida. ♔ El Rey (Visión del CEO) Es la pieza más importante… y la más vulnerable. Si la visión estratégica y ética cae, el proyecto muere. ♙ Los Peones (Datos y tareas) Un peón aislado es un dato en silo. Una cadena de peones es una estructura de datos sólida que genera ventaja competitiva. 🔹 Medio juego: activar a los disruptores Aquí no se gana con grandes despliegues precipitados, sino con precisión. ♘ Caballos (Agentes IA y talento especializado) Saltan la burocracia, rompen bloqueos y abren nuevas oportunidades de innovación. ♗ Alfiles (Casos de uso) Conectan departamentos, atraviesan silos y convierten estrategia en ejecución. ♕ La Dama (Estrategia de IA) No es un proyecto. Es la pieza que coordina a todas las demás para que humano y máquina aporten valor real. 🔹 Final: la regla del Centauro La IA sola puede calcular mejor que cualquier humano. Pero Humano + Máquina (Centauro) vence a la máquina aislada. Tu rol como CEO no es programar algoritmos. Es decidir dónde, cuándo y qué sacrificar para ganar la partida. 🚀 El movimiento final La IA calcula millones de probabilidades por segundo. Pero la decisión —y la responsabilidad— sigue siendo tuya. El aumento potencial de productividad puede superar el +40 %, pero solo para quienes entienden que esto no va de tecnología, sino de estrategia. El tablero ya está dispuesto. La pregunta es simple: 👉 ¿mueves tú… o dejas que la inercia decida por ti? ¿Qué pieza le está costando más mover hoy a tu empresa? ¿Los peones (datos) o los caballos (talento)? Soy Joaquín Rieta, formador y consultor. Ayudo a empresas a implantar IA con método y visión estratégica 📊🧭 www.joaquinrieta.com

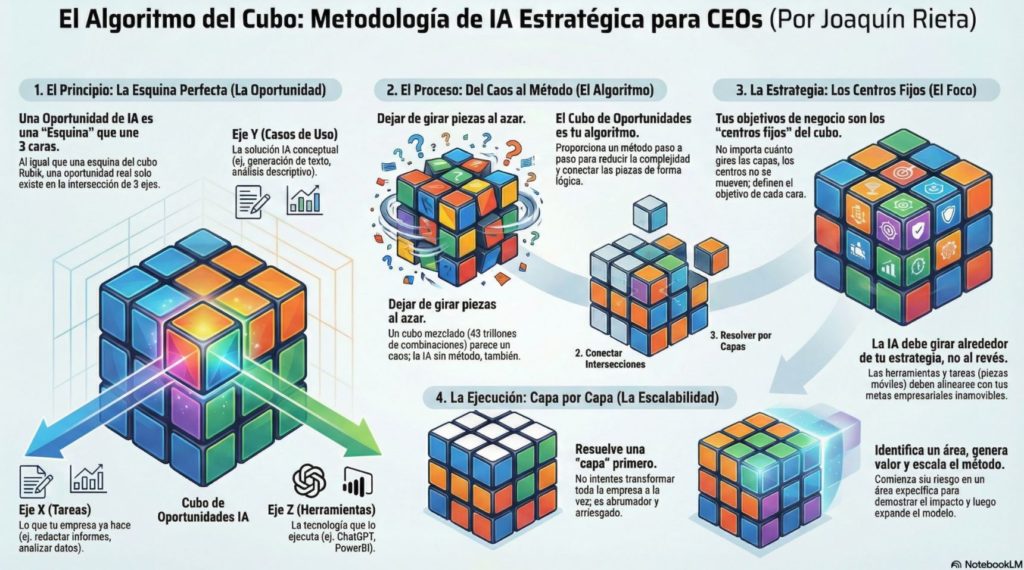

El Algoritmo del Cubo: cómo un CEO debe pensar la IA

Muchos CEOs hoy tienen la sensación de que la IA es potente… pero caótica. Herramientas por todas partes. Ideas sueltas. Automatizaciones aisladas. Como un cubo de Rubik mezclado que gira … pero no avanza. La IA no falla por falta de tecnología. Falla por falta de método. Y aquí es donde entra el Algoritmo del Cubo 👇 1️⃣ El principio: la esquina perfecta (la oportunidad) En un cubo de Rubik, una esquina solo está bien colocada cuando encajan tres caras a la vez. En IA ocurre exactamente lo mismo. Una oportunidad real de IA solo existe cuando confluyen: 🔹 Tareas reales del negocio (lo que ya haces) 🔹 Casos de uso claros (cómo mejorar eso) 🔹 Herramientas concretas (con qué lo ejecutas) Si falta uno de los tres, no es estrategia. Es experimentación sin retorno. 2️⃣ El proceso: del caos al método (el algoritmo) Un cubo tiene 43 trillones de combinaciones posibles. La IA en una empresa, también. Sin método: se gira al azar se prueba “lo que está de moda” se confunde movimiento con avance El Cubo de Oportunidades IA no es una metáfora bonita: es un sistema para reducir complejidad, conectar intersecciones y decidir con lógica. Menos ruido. Más criterio. 3️⃣ La estrategia: los centros fijos (el foco) En el cubo hay una regla inmutable: 👉 los centros no se mueven. En tu empresa, esos centros son: tu estrategia tus objetivos tu modelo de negocio La IA debe girar alrededor de eso. Nunca al revés. Si cambias tu dirección para encajar una herramienta, has perdido el control del cubo. 4️⃣ La ejecución: capa por capa (la escalabilidad) Nadie resuelve un cubo de una sola vez. Y nadie debería transformar una empresa entera de golpe con IA. El orden importa: 1️⃣ Empieza por una capa concreta 2️⃣ Genera valor visible 3️⃣ Demuestra impacto 4️⃣ Escala el método Eso es liderazgo. Eso es visión. 🎯 Conclusión La IA no es un proyecto tecnológico. Es un sistema de decisiones. Quien tiene método, avanza. Quien no, gira piezas. 🎁 Si te perdiste mi Black Friday, te mantengo el descuento hasta el 31 de diciembre en mi curso estratégico de IA para CEOs. 👉 Busca el descuento en mis publicaciones 👉 Escríbeme a joaquin.rieta@gmail.com Soy Joaquín Rieta, formador y consultor. Ayudo a empresas a implantar IA con método y visión estratégica 📊🧭 🌐 www.joaquinrieta.com

CEO, ¿Tu plantilla actual está lista para llegar operativa a 2030?. No basta con digitalizar procesos.

Según el Future of Jobs Report 2025 del World Economic Forum, estamos ante una reconfiguración profunda del talento: nuevas competencias, nuevas prioridades, nuevos riesgos. Tu responsabilidad no es solo contratar talento, sino reconstruirlo desde dentro. Esta es la Matriz de Competencias 2030 que debe guiar tu estrategia de RR.HH. para mantener la competitividad. 🚀 1. COMPETENCIAS NUCLEARES (El Motor) Alta relevancia actual + fuerte crecimiento futuro. Son innegociables. Si tu equipo no las domina, quedas fuera de juego. ✅ Tecnológicas: IA, Big Data, alfabetización digital. ✅ Cognitivas: pensamiento analítico, creativo y sistémico. ✅ Humanas: resiliencia, liderazgo, aprendizaje continuo, gestión del talento, motivación. ✅ Sociales: empatía, escucha activa, orientación al cliente. 🌱 2. COMPETENCIAS EMERGENTES (La Apuesta) Aún poco comunes, pero en rápida expansión. Invertir aquí ahora es ganar ventaja anticipada. 🔹 Ciberseguridad y redes. 🔹 Sostenibilidad y gestión medioambiental. 🔹 Experiencia de Usuario (UX) y diseño centrado en personas. ⚓ 3. COMPETENCIAS ESTABLES (Los Cimientos) Claves para la operativa diaria, con crecimiento moderado. No innovan, pero sostienen el sistema. 🔸 Gestión de operaciones y recursos. 🔸 Enseñanza y mentoría interna. 🔸 Fiabilidad, precisión y control de calidad. ⚠️ 4. ÁREAS EN TRANSFORMACIÓN (Fuera de Foco) Perfiles que están siendo automatizados. No necesitas despedir, sino reconvertir (reskilling) hacia los grupos 1 y 2. 🔻 Procesos manuales y repetitivos. 🔻 Redacción básica, cálculos elementales. 🔻 Programación simple (ya cubierta por asistentes de código). 🔻 Marketing y diseño tradicional (impactados por IA generativa). 🔻 Multilingüismo (reducido por traducción automática). 💡 TU MISIÓN COMO CEO La IA es el disruptor. Pero el diferencial seguirá siendo humano. Las habilidades socioemocionales son ahora tu principal ventaja competitiva. Soy Joaquín Rieta, formador y consultor en Inteligencia Artificial para CEOs y equipos directivos 🤝🧠. Ayudo a empresas a implantar IA con método, gobernanza y visión estratégica 📊🧭. www.joaquinrieta.com hashtag#CEO hashtag#Liderazgo hashtag#FutureOfJobs hashtag#WEF hashtag#Talento2030 hashtag#Estrategia hashtag#RRHH hashtag#Reskilling hashtag#TransformaciónHumana

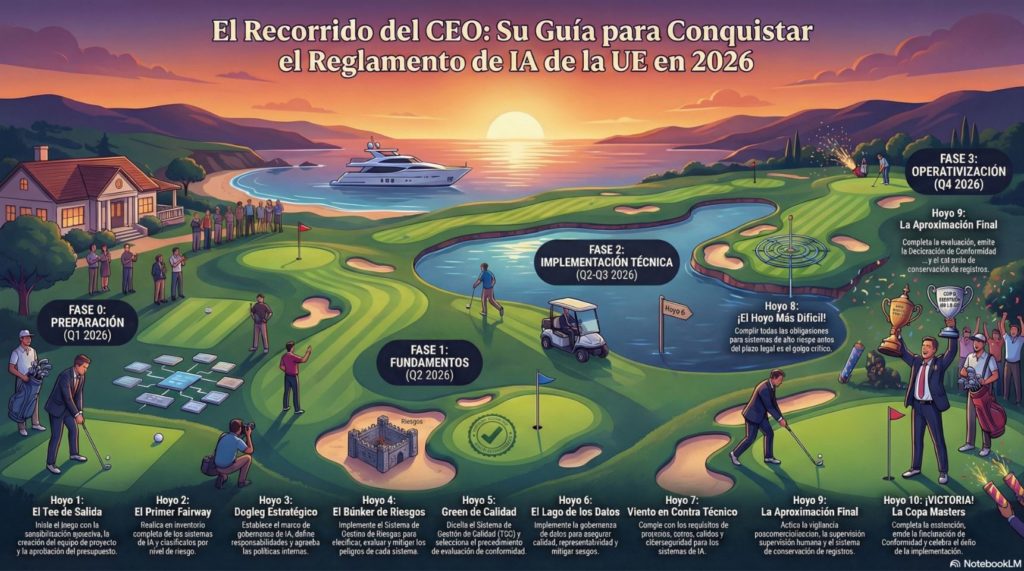

CEO UPDATE | Reglamento de IA: nueva estrategia 2026.

¿Tu hoja de ruta de IA sigue marcada en rojo para el 2 de agosto de 2026? Hora de actualizar. En noviembre de 2025, la Comisión Europea presentó el Ómnibus Digital sobre la IA, reforma del Reglamento 2024/1689. ¿Su objetivo? Eliminar burocracia innecesaria, dar más tiempo y ofrecer ventajas a empresas ágiles y Small Mid-Caps (SMC). 🧭 El foco ya no es solo “cumplir o ser sancionado”. Es convertir el cumplimiento en ventaja competitiva. 📌 PLAN ÓMNIBUS 2026: LA NUEVA RUTA ESTRATÉGICA Fases claras, responsables definidos, resultados medibles. 1️⃣ DIAGNÓSTICO DE OPORTUNIDAD (Q1 2026) 🔍 Antes de gastar, entiende tu posición bajo la nueva norma. 📝 Auditoría rápida: • ¿Somos SMC? (<750 empleados y <150M€ facturación) • ¿Qué sistemas de IA usamos? ¿Son realmente de alto riesgo? 🎯 Validación SMC = acceso a formularios simplificados y sandboxes prioritarios 📈 Resultado: Reducción del inventario regulado → menos carga, más foco 2️⃣ GOBERNANZA RACIONALIZADA (Q2 2026) ⚖️ No formes a toda la plantilla si solo un 5% toma decisiones sobre IA. 📝 Redefine la estrategia de formación: • Estados asumen la alfabetización general • Las empresas enfocan recursos solo en vigilancia técnica 🎯 Capacitación dirigida a roles clave (IT/Legal) 📈 Resultado: Gobernanza efectiva con inversión mínima 3️⃣ GESTIÓN DEL TIEMPO (Deadline Flotante) ⏳ La cuenta atrás empieza solo cuando existan estándares. 📝 Alinea los esfuerzos técnicos a la publicación de estándares armonizados 🎯 Evita rediseños prematuros 📈 Resultado: Roadmap técnico flexible y eficiente 4️⃣ CONFORMIDAD TÉCNICA SIMPLIFICADA (Q3-Q4 2026) 🧾 Documenta mejor, no más. 📝 Implementa un Sistema de Gestión de Calidad (SGC) proporcional 🎯 Usa los nuevos formularios SMC para evaluación técnica 🎯 Activa excepciones legales para tratamiento justo de datos 📈 Resultado: Dossier listo para auditoría sin bloquear operaciones 💡 ¿POR QUÉ ACTUAR AHORA? 📉 La inacción cuesta: más esfuerzo, más sanción, menos control 📈 La estrategia inteligente anticipa, prioriza y libera recursos El Ómnibus Digital recompensa a quien se adapta con agilidad. 🚀 No diseñes un traje demasiado grande si puedes vestir a medida. Revisa ya tu hoja de ruta para la IA de 2026. Soy Joaquín Rieta, formador y consultor en Inteligencia Artificial para CEOs y equipos directivos 🤝🧠. Ayudo a empresas a implantar IA con método, gobernanza y visión estratégica 📊🧭. www.joaquinrieta.com hashtag#AIAct hashtag#DigitalOmnibus hashtag#CEO hashtag#SMC hashtag#Compliance hashtag#IAResponsable hashtag#2026Ready hashtag#RegulaciónEstratégica hashtag#EULaw

CEO, ¿recuerdas el famoso eslogan “si bebes, no conduzcas”?

Con la Inteligencia Artificial ocurre exactamente lo mismo. Si en tu “bebida enegértica inteligente” mezclas prisa, automatización y falta de control 🍸⚡, la decisión no será estratégica… será errónea. ⚠️ Al principio todo parece ir bien: 🚗 velocidad, ⚡ eficiencia, 🤖 automatización. La llamada implantación acelerada resulta tentadora. Pero cuando la IA se implanta sin diagnóstico, sin gobernanza y sin supervisión, el camino empieza a torcerse. Primero aparecen los riesgos ⚠️ 🔴 Falta de transparencia en chatbots y contenido sintético 🔴 Datos sesgados en RRHH que derivan en discriminación 🔴 Automatización ciega sin control humano Luego llegan las señales claras de peligro 🚧 ❌ Sin gobernanza ❌ Sin logs ❌ Sin control humano Y cuando nadie frena a tiempo, el impacto no es tecnológico. Es legal, reputacional y estratégico 💥⚖️📉 Aquí es donde entra el Nuevo Reglamento Europeo de IA 🚑🇪🇺 No para frenar la innovación, sino para evitar que el accidente sea irreversible. La alternativa existe: 🛣️ una ruta más lenta, pero segura 📋 diagnóstico 🏛️ gobernanza 👁️ supervisión humana ✅ cumplimiento Porque al final la decisión no es técnica. Es estratégica. ¿IA rápida… o IA segura? La diferencia entre una y otra puede decidir el futuro de tu empresa. Soy Joaquín Rieta, formador y consultor en Inteligencia Artificial para CEOs y equipos directivos 🤝🧠. Ayudo a empresas a implantar IA con método, gobernanza y visión estratégica 📊🧭. www.joaquinrieta.com hashtag#IA hashtag#CEO hashtag#GobernanzaIA hashtag#ReglamentoUEIA hashtag#Liderazgo hashtag#EstrategiaEmpresarial hashtag#Compliance

CEOs, trabajadores: os quedan «solo» 5 años o incluso menos.

Fórmate. Todos jugamos un número en la lotería del desempleo alguna vez en la vida y, puede tocarnos. España concentra el 72,3 % del paro registrado en el sector servicios. Y, precisamente, ese es el mismo sector que la IA amenaza con automatizar masivamente en los próximos años. La transición no es opcional: es urgente. Según el Future of Jobs Report 2025 del WEF, estas son las claves de lo que viene: 📉 LOS PUESTOS EN PELIGRO (Y POR QUÉ) En España, los roles administrativos y de oficina son los más vulnerables. Se prevé una caída masiva en: ❌ Asistentes administrativos y secretarios (-29%). ❌ Empleados de registro de datos (-27%). ❌ Contabilidad y nóminas (-24%). La razón: Se espera que para 2027, el 34% de las tareas rutinarias (procesamiento de datos, cálculo básico) se automaticen. 🏗️ LA EXCEPCIÓN: HOSTELERÍA Y CONSTRUCCIÓN Curiosamente, aunque sufren alta rotación, los robots aún tienen limitaciones «altas» para sustituir la destreza manual compleja. 🚀 LA SOLUCIÓN: UNA ESTRATEGIA A TRES BANDAS Para mitigar este impacto y aprovechar los 170 millones de nuevos empleos que se crearán globalmente, necesitamos actuar ya: 1️⃣ Administración Pública: La prioridad debe ser la financiación del Reskilling. El 64% de las empresas en España ve esto como la medida política más efectiva. Necesitamos agilidad educativa en competencias STEM y apoyo a los colectivos vulnerables (+45 años). 2️⃣ Empresas: La «escasez de talento» es la barrera nº1. La solución no es despedir, sino la Movilidad Interna: recualificar a administrativos para roles en auge (como gestión de datos). 💡 Dato clave: Apoyar el bienestar de los empleados es ahora la práctica nº1 para asegurar talento, por encima de la promoción. 3️⃣ Profesionales: El 39% de tus competencias básicas cambiarán en 5 años. Tu refugio ante la automatización son las Habilidades Humanas: ✅ Pensamiento analítico y creativo. ✅ Resiliencia y flexibilidad. ✅ Alfabetización en IA (aprende a usarla, no a temerla). El futuro no va de que los robots nos quiten el trabajo, sino de cerrar la brecha entre las capacidades actuales y las nuevas demandas. Fuente: INE, SEPE, Ministerio de Trabajo y Economía Social, Ministerio de Inclusión, Seguridad Social y Migraciones, Ministerio de Educación y Formación Profesional (MEFP), Ministerio de Economía, Comercio y Empresa (MINECO), ONTSI, Banco de España, OIT (ILO), Eurostat, Comisión Europea, OCDE, FMI, Banco Mundial, OMC, UNESCO, Cedefop, EIGE, UNECE, Foro Económico Mundial (WEF), DigitalES, CaixaBank Dualiza, Orkestra-Instituto Vasco de Competitividad, Randstad Research, Confederación Canaria de Empresarios, Fundación FOESSA, Fundación BBVA-IVIE, Fundación Universia, Fundae, SEPIE, IFR, AEDIPE, Bankinter, Educaweb, InfoJobs, LinkedIn, Indeed, Coursera, ADP Research, Job Market Insights y Reddit. hashtag#FutureOfJobs hashtag#IA hashtag#Reskilling hashtag#RecursosHumanos hashtag#EmpleoEspaña hashtag#TransformacionDigital hashtag#Talento

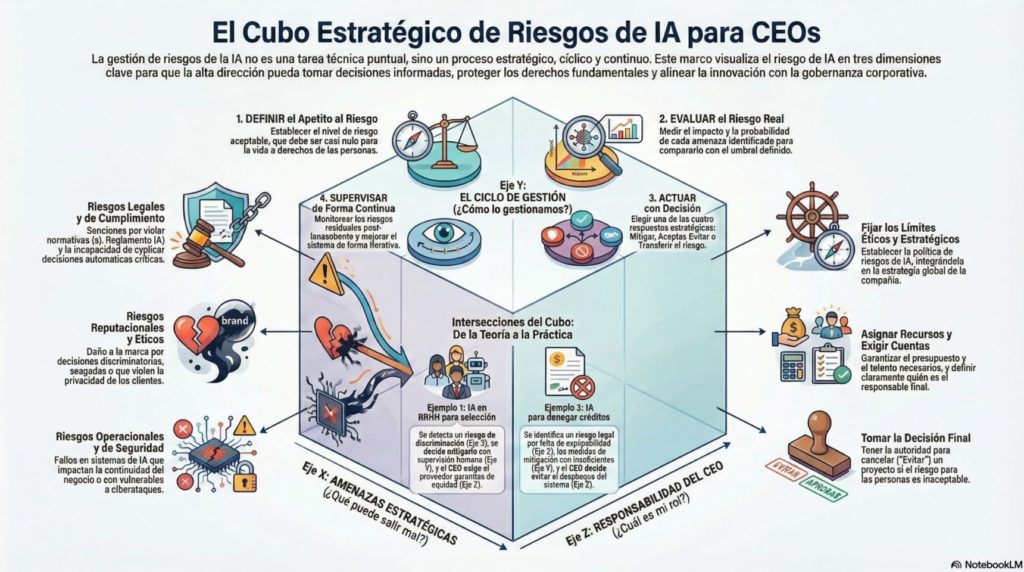

El Cubo Estratégico de Riesgos del uso de la Inteligencia Artificial: mi marco de decisión para CEOs

A muchos CEOs les ocurre lo mismo: saben que la IA puede transformar su empresa 🚀, pero no tienen claro qué riesgos están asumiendo, quién los controla ni cuándo deben frenar una decisión 🛑. La complejidad no está en la tecnología ⚙️. Está en gobernarla 🧭. La gestión del riesgo en IA no es un checklist técnico 📋 ni una tarea puntual. Es un proceso estratégico, continuo y de responsabilidad directa del CEO 👔. El problema aparece porque el riesgo de la IA suele analizarse de forma fragmentada 🧩, cuando en realidad vive en tres dimensiones que deben conectarse 🔗: 1️⃣ Las amenazas estratégicas ⚠️ – Riesgos legales y de cumplimiento ⚖️📜 – Riesgos reputacionales y éticos 🧠❤️🔥 – Riesgos operacionales y de seguridad 🔐💥 2️⃣ El ciclo de gestión del riesgo 🔄 – Definir el apetito al riesgo 🎯 – Evaluar impacto y probabilidad 📊 – Decidir: mitigar, aceptar, transferir o evitar 🧯🤝🚫 – Supervisar y corregir de forma continua 👁️🔁 3️⃣ La responsabilidad del CEO 🧑💼 – Fijar límites éticos y estratégicos 🧭⚖️ – Asignar recursos y exigir cuentas 💰📌 – Tomar la decisión final, incluso cancelar proyectos 🛑✋ El problema es que cada uno de estos elementos suele vivir en contextos distintos 🏗️: – El riesgo se ve como algo técnico ⚙️ – La ética como algo teórico 📚 – La decisión como algo delegable 👥 Cuando un CEO intenta unirlo todo, aparece la confusión 🤯: 👉 ¿Qué puede salir realmente mal con este uso de IA? 👉 ¿Qué riesgos son aceptables y cuáles no? ⚠️ 👉 ¿Quién responde si el sistema falla o discrimina? ❓ Aquí es donde nace el Cubo Estratégico de Riesgos de IA 🔷: un marco visual que permite conectar Amenazas, Gestión y Responsabilidad de forma clara, ejecutiva y sin ambigüedades 🧠📐. Cada intersección del cubo traduce la teoría en decisiones reales 💼: – Supervisión humana obligatoria en sistemas críticos 👁️🧍 – Cancelación de proyectos con riesgo inaceptable 🚫📉 – Exigencia de explicabilidad y garantías a proveedores 📄🔍 – Alineación entre innovación, ética y gobernanza corporativa 🧭🏢 Cuando un CEO observa este cubo, ocurre algo clave 🔑: ✓ Deja de ver la IA como un experimento tecnológico 🧪 ✓ Empieza a verla como un riesgo empresarial que debe gobernar 🛡️ ✓ Recupera el control de la decisión final 🎯 La transformación no está en usar más IA 🤖. Está en usar IA con criterio, límites y responsabilidad ⚖️🧠. Porque en IA, no decidir también es una decisión ⚠️. El CEO tiene que: – Anticipar riesgos antes de que sean crisis 🔮 – Proteger a las personas y a la compañía 🧍♂️🧍♀️🏢 – Innovar sin perder el control 🚀🛑 Soy Joaquín Rieta, formador y consultor en Inteligencia Artificial para CEOs y equipos directivos 🤝🧠. Ayudo a empresas a implantar IA con método, gobernanza y visión estratégica 📊🧭. www.joaquinrieta.com

CEO, pasa de 0 a 100 en tracción comercial con el RS 72 en redes sociales.

Yo también tuve ese problema cuando empecé. Exactamente el mismo 👇 📉 Visitas al perfil casi testimoniales 👍 Publicaciones con pocos o ningún like 💬 Comentarios escasos y siempre de la misma gente 📈 Seguidores que suben a un ritmo desesperantemente lento Probé los dos caminos que casi todo CEO prueba: 🔹 Hacerlo yo mismo Entre reuniones, urgencias y decisiones. Sin tiempo real para pensar una estrategia de contenidos seria. 🔹 Delegarlo en una agencia de marketing Creatividades bonitas, algún calendario de publicaciones… pero sin una estrategia clara ligada a mi producto, a mis clientes y a mis objetivos de negocio. El resultado siempre era el mismo: Contenido que “estaba bien”, pero no impactaba, no diferenciaba y no vendía. Ahí entendí algo clave 👇 👉 el problema no era el esfuerzo, era la falta de método. Y así nació RS 72 🏎️ 🏁 LAS ETAPAS DEL RS 72 🛑 Etapa 1 · Subirse al RS 72 Dejas de improvisar y decides recorrer el circuito con método. Cambia de actitud, confía en tu copiloto. 🔍 Etapa 2 · Diagnóstico 360º Analizamos producto, servicios, clientes, necesidades, redes, web y competencia. Usamos PROMPTs específicos con IA y adaptamos la Pirámide de Maslow para detectar nichos, oportunidades e innovación. ✍️ Etapa 3 · Escribir lo que vende Psicolingüística + análisis léxico-gramatical. Empiezas a escribir lo que tus lectores quieren y necesitan leer. Aquí nace un post viral o un superventas. ⛽ Etapa 4 · Contenido para 12 meses Definimos mínimo 30 temas estratégicos, priorizando los que convierten en ventas. Diseñamos el plan anual de contenidos con IA. 🧩 Etapa 5 · Estrategia de cada publicación Cada post se diseña con objetivo, estructura, gancho, mensaje, perfil del lector y formato. Con imágenes, fotos, infografías, vídeos, avatares…. Nada se deja al azar. 📊 Etapa 6 · Medir y ajustar Seguidores, comentarios, compartidos, visitas y oportunidades comerciales. Se mide, se corrige y se optimiza. Con dashboard y Kpis de seguimiento. 🔁 Etapa 7 · Repite todas las etapas Más vueltas al circuito para mejorar rendimiento y conversión. Afina el método, sigue adaptándolo y perfeccionándolo. Sigo de copiloto. 🏆 META No te esperan likes vacíos, te esperan muchas oportunidades. Aprovéchalas. Te esperan clientes con dinero, con intención real de compra. ✅ RS 72 no es publicar más. ✅ Es convertir contenido en negocio. 👋 Soy Joaquín Rieta, tu copiloto IA. Soy formador y consultor de Inteligencia Artificial. Ayudo a CEOs a convertir la Inteligencia Artificial en estrategia, ventaja y visión de futuro cumpliendo el nuevo Reglamento IA. www.joaquinrieta.com