La sostenibilidad del empleo: una responsabilidad y un compromiso social empresarial en la era de la Inteligencia Artificial

🌍💡 La sostenibilidad del empleo: una responsabilidad y un compromiso social empresarial en la era de la Inteligencia Artificial (IA) 💼🤖 Cada revolución tecnológica ha impactado en el empleo. La Revolución Industrial desplazó a los artesanos con máquinas, pero creó fábricas y nuevos puestos. La informática eliminó muchos trabajos administrativos, pero generó la industria del software. Ahora, la IA vuelve a transformar el mercado laboral. 📊 Según el informe «Impulsando el crecimiento de España: el papel de las tecnologías, la IA y las multinacionales», coordinado por Andrés Pedreño Muñoz, en España hasta 2 millones de empleos podrían verse amenazados en sectores como hostelería, comercio y administración. Sin embargo, la IA también podría generar 1,61 millones de nuevos empleos en áreas de alto valor añadido como los servicios financieros, la programación y la consultoría. 🔄 Destrucción creativa y el empleo en la era de la IA El concepto de destrucción creativa de Schumpeter, explica cómo la innovación sustituye ciertos empleos, pero a la vez impulsa nuevas industrias y oportunidades laborales. ♿ IA y la inclusión laboral La IA no solo transforma el empleo, sino que también abre nuevas oportunidades para la inclusión laboral. Con herramientas de accesibilidad y automatización, facilita la integración de personas con discapacidad, eliminando barreras que antes limitaban su acceso al mercado laboral. 🌱 El liderazgo empresarial ante la IA: más allá de los beneficios 🏢💙 No se trata solo de reducir costes o aumentar la productividad. Los empresarios/as tenemos la responsabilidad de humanizar este cambio. Despedir empleados por implantar la IA sin alternativas no es una opción sostenible. ✋ Antes de despedir, hay que reconvertir y formar 📚🔄 La IA no solo sustituye trabajos, también requiere nuevas competencias. ¿Por qué no capacitar a nuestros equipos para convivir con la IA en un modelo híbrido? La formación y la reinvención profesional deben ser nuestra primera opción. 🛠️ Si no es posible reubicar, acompañar 🤝 Cuando la IA haga inevitable una reestructuración, los empresarios/as debemos ofrecer asesoramiento y programas de orientación laboral para facilitar nuevas oportunidades. El impacto social de la IA es nuestra responsabilidad. 🚀 La IA no es una amenaza, sino una oportunidad 💡💪 Existe un tsunami de formación sobre IA. Ya no hay excusas. La actitud y la iniciativa son clave. La IA cambiará el mundo, pero depende de nosotros que lo haga de forma justa y equilibrada. 💼 Mi compromiso con el empleo comienza por incluir en la formación que imparto sobre IA 🤖, un módulo de sostenibilidad del empleo 🌍 donde explico iniciativas y acciones 🛠️ para reducir su impacto negativo📉. 💬 ¿Cómo crees que podemos equilibrar la adopción de IA y la sostenibilidad del empleo? Te leo en comentarios 👇😊 hashtag#InteligenciaArtificial hashtag#Empleo hashtag#Liderazgohumano hashtag#Empresas hashtag#FuturoDelTrabajo hashtag#Liderazgoconsciente hashtag#InteligenciaResponsable

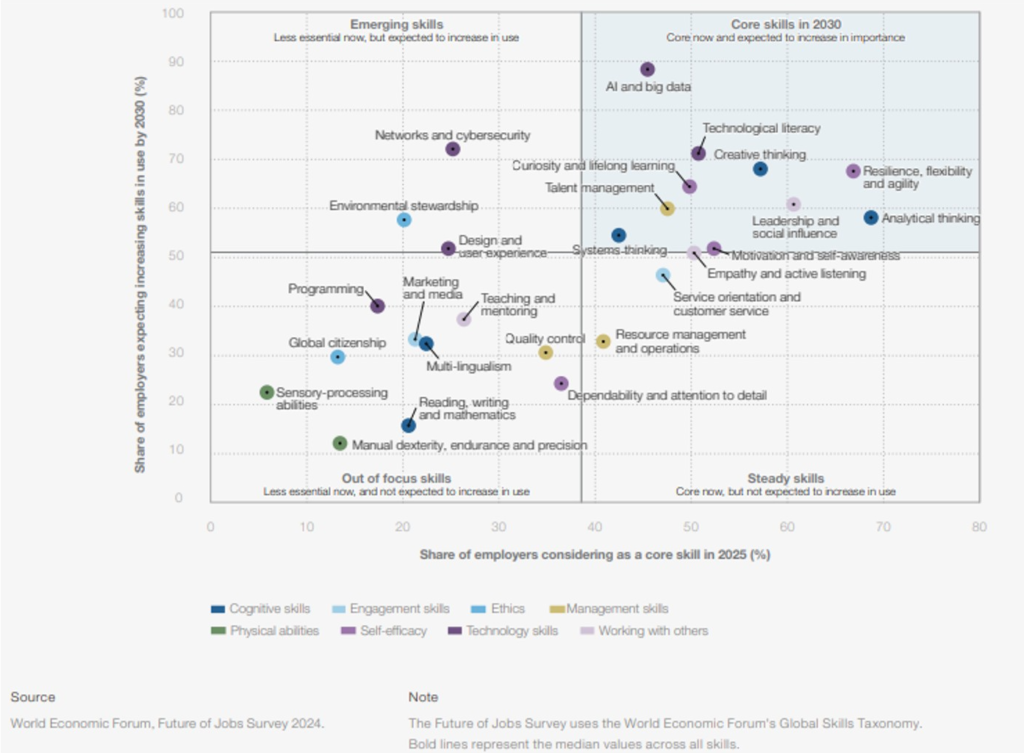

Las 9 habilidades de Inteligencia Artificial que salvarán tu empleo en 2030

🤖 Las 9 habilidades de Inteligencia Artificial que salvarán tu empleo en 2030. Imprime el gráfico del World Economic Forum y cuélgalo donde todo el mundo lo vea; al lado de la cafetera, encima del extintor, en el baño….. 🙂 El Future of Jobs Report 2025 del Foro Económico Mundial (WEF) publica en su página 41 una matriz clave, la Figura 3.6 Core skills in 2030. 📊 El gráfico divide las habilidades en 4 categorías: 🔹 Habilidades clave en 2030: ya son esenciales y crecerán más 🟡 Habilidades emergentes: aún poco valoradas, pero en rápido ascenso 🟤 Habilidades estables: se mantienen, pero no crecerán 🔻 Habilidades fuera de foco: en retroceso Puedes descargar el informe del WEF en https://lnkd.in/d2_cZwuJ Y aunque todas son importantes, si tu empresa quiere adaptarse a la IA, hay 9 que pueden marcar la diferencia. 🤖 Inteligencia Artificial y Big Data 🧠 Pensamiento Analítico 💻 Alfabetización Tecnológica 👨💻 Programación 🔐 Redes y Ciberseguridad 🔄 Pensamiento Sistémico 🎨 Pensamiento Creativo 📚 Curiosidad y Aprendizaje Permanente ⚡ Resiliencia, Flexibilidad y Agilidad 🧭 Esta podría ser la ruta de aprendizaje para tu empresa: 🔸 Fase 1 – Fundamentos Competencias en transformación digital 👉 Formación: Procesos, introducción a la IA y herramientas IA 👥 Puestos: Toda la plantilla, especialmente administración, marketing y ventas 🔸 Fase 2 – Análisis y Cultura Pensamiento analítico 👉 Formación: Power BI, Excel y Google sheet. 👥 Puestos: Dirección, ventas y responsables de procesos Curiosidad y aprendizaje continuo 👉 Formación: Creatividad, productividad y métodos ágiles 👥 Puestos: Mandos intermedios y perfiles innovadores Toma de decisiones y análisis 👉 Formación: Gestión del riesgo, decisión basada en datos y matrices de decisión 👥 Puestos: Gerencia y responsables de área 🔸 Fase 3 – Aplicación de la IA IA y analítica de datos 👉 Formación: Ciencia de datos, machine learning para no técnicos 👥 Puestos: Dirección técnica, analistas y producción Pensamiento crítico 👉 Formación: Resolución de problemas, evaluación de información 👥 Puestos: Responsables de análisis y atención al cliente 🔸 Fase 4 – Creatividad y Escalado Pensamiento creativo 👉 Formación: Design Thinking, IA generativa, prompts 👥 Puestos: Marketing, diseño y desarrollo de servicios Redes y Ciberseguridad 👉 Formación: Ciberseguridad básica, protección de datos y cumplimiento normativo IA 👥 Puestos: IT, operaciones y compliance Programación 👉 Formación: Python, APIs y automatización de tareas 👥 Puestos: Perfiles técnicos, desarrolladores y soporte interno 🔁 Me interesa mucho tu punto de vista, te leo en comentarios. Muchas gracias. hashtag#IA hashtag#Habilidades2030 hashtag#FutureOfJobs hashtag#WEF hashtag#WorldEconomicForum hashtag#TransformaciónDigital hashtag#PYMES hashtag#Empleo hashtag#Formación hashtag#Talento hashtag#FuturoDelTrabajo

Y si Aristóteles fuera el CEO de OpenAI… y Sócrates el Ingeniero de PROMPTs de ChatGPT

🧠 Y si Aristóteles fuera el CEO de OpenAI… y Sócrates el Ingeniero de PROMPTs de ChatGPT ¿Estamos automatizando decisiones más rápido de lo que las pensamos? 📜 Sócrates (470–399 a.C., Atenas) 🗣️ No escribió nada. Enseñaba preguntando. 💭 Su método era la mayéutica: provocar el pensamiento mediante el diálogo, la contradicción y la conciencia de no saber. ⚖️ Murió por “corromper a la juventud”… por atreverse a cuestionarlo todo. No daba respuestas: enseñaba a pensar mejor. En un mundo saturado de inputs, su mirada nos recuerda que el conocimiento no es información, es comprensión activa. 📚 Aristóteles (384–322 a.C., Estagira) 🧠 Discípulo indirecto de Sócrates. 🔎 Fundó la lógica formal, la ética práctica y la idea de que todo tiene una finalidad (telos). 🏛️ Clasificó el saber humano, organizó el pensamiento y propuso que la virtud nace del hábito. Para él, el conocimiento debía conducir a la acción correcta, no solo a saber más. Hoy, su visión es imprescindible. 🏛️ Su legado sigue vivo (y nos toca directamente): 🔹 Sócrates nos enseñó a no aceptar respuestas sin pensar, ni siquiera las de un modelo de IA. 🔹 Aristóteles, a buscar el equilibrio, el propósito y la virtud en nuestras decisiones, incluso tecnológicas. Ambos compartían algo esencial: la búsqueda del sentido. Y eso es justo lo que más le falta a muchas implementaciones de IA. 🤖 ¿Qué tiene esto que ver con la IA?. Todo. ✔️ Sócrates sería hoy el mejor prompt engineer del mundo: Su diálogo basado en preguntas críticas es la raíz del diseño conversacional moderno. ChatGPT responde, pero sin buenas preguntas, la inteligencia no se activa. El valor no está en la respuesta, sino en cómo preguntas. ✔️ Aristóteles sería el estratega ético que necesitamos: Su lógica formal es el antepasado de los algoritmos y los sistemas expertos. Su phronesis (sabiduría práctica) es el ingrediente que falta en muchos modelos actuales. Nos recordaría que no basta con automatizar: hay que saber para qué, para quién y con qué consecuencias. 📈 Como CEO, la reflexión ya no es técnica. Es filosófica: ✅ ¿Qué finalidades tiene la IA en tu empresa? ✅ ¿La estás usando para acelerar… o para pensar mejor? ✅ ¿Tus decisiones se guían por eficiencia… o por virtud? ✅ ¿Estás formando a tu equipo en pensamiento crítico o solo en herramientas? 🧩 Quizá la pregunta no sea si usar IA, sino cómo y con qué valores. Y si Aristóteles viera tu dashboard… ¿diría que es virtuoso o solo funcional? Y si Sócrates leyera tus prompts… ¿diría que te guían al saber o solo al ruido? 📩 ¿Quieres aplicar esta mirada estratégica y humana a tu negocio? Hablemos. La filosofía no está en el pasado. Está en el próximo prompt.

Cuando veas alucinar los ojitos de la IA, sigue esta estrategia.

🚨 Cuando veas alucinar los ojitos de la IA, sigue esta estrategia. 💡Consejos para CEOs: paso a paso para reducir las alucinaciones de ChatGPT 🤖 La IA generativa puede parecer brillante hasta que te das cuenta de que se ha inventado una ley, un dato o una cita que no existe. Eso es una alucinación de la IA: cuando responde con información incorrecta, imprecisa o falsa, pero con total seguridad. 📏 La versión gratuita de ChatGPT (GPT-3.5) trabaja con un límite de 4.096 tokens por conversación, lo que equivale aproximadamente a 3.000 palabras. En cambio, la versión de pago con GPT-4o puede manejar hasta 128.000 tokens, lo que le permite recordar mejor el contexto, trabajar con documentos largos o mantener conversaciones más extensas. 🔍 Ejemplo real: Le subes una ley en PDF (2.000 tokens) y le preguntas por un artículo (323 tokens). La IA te responde con un resumen convincente pero el artículo no dice eso o ni siquiera existe. ¿Por qué ocurre esto? 🎯 Factores clave que influyen en las alucinaciones 📚 Datos de entrenamiento La IA aprende de grandes volúmenes de información. Si esos datos son antiguos, sesgados o limitados, las respuestas reflejan ese error. 🧠 Versión del modelo Modelos más avanzados (como GPT-4 Turbo) alucinan menos. En versiones gratuitas como GPT-3.5, el riesgo es mayor. 📏 Límite de tokens (memoria) Si la conversación o el PDF es largo, el modelo “olvida” parte de la información, lo que puede llevar a errores. 🧾 Prompt mal diseñado Prompts sin contexto o mal estructurados aumentan la confusión del modelo. 🧩 Tipo de tarea Preguntas abiertas, complejas o que requieren interpretación legal, estratégica, son terreno propenso a errores. 🧠 Gist Token mal interpretado La IA resume mentalmente el documento que lee. Si malinterpreta el sentido general, la respuesta estará mal orientada desde el principio. 🧷 Técnicas avanzadas como RAG (Retrieval-Augmented Generation) Aunque RAG reduce alucinaciones al usar fuentes externas (como tus propios documentos), no es infalible si se recupera información irrelevante, se resumen mal los textos o no se estructuran bien los datos. 💡 ¿Cómo reducir al máximo las alucinaciones? ✔ Usa siempre modelos actualizados. ✔ Optimiza tus prompts con contexto, rol y claridad. ✔ Limita la longitud de entrada (tokens) o divide el contenido. ✔ Supervisa las respuestas, especialmente en temas críticos. ✔ Revisa cómo has cargado tus documentos: la estructura importa. ✔ Aplica técnicas como RAG, pero con fuentes fiables y supervisión. 👉 No es magia, es método. La clave no está solo en el modelo, sino en cómo lo usas. Y eso sí depende de ti. En próximas publicaciones os presentaré la Teoría de las 10 CEs que he diseñado para mejorar tu comunicación con las IAs. ¿Te has encontrado con alguna “alucinación” de la IA?. ¿Cómo lo solucionaste?.